Trio vědců z University of North Carolina v Chapel Hill nedávno zveřejnilo [1] předtiskový výzkum umělé inteligence (AI), který ukazuje, jak obtížné je odstranit citlivá data z velkých jazykových modelů (LLM), jako je ChatGPT společnosti OpenAI a Bard společnosti Google.

Podle studie výzkumníků je úkol „smazat“ informace z LLM možný, ale je stejně obtížné ověřit, zda byly informace odstraněny, jako je skutečně odstranit.

Důvodem je to, jak jsou LLM navrženy a vyškoleny. Modely jsou předtrénovány v databázích a následně vyladěny tak, aby generovaly koherentní výstupy (GPT znamená „generativní předtrénovaný transformátor“).

Černá skříňka AI

Jakmile je model trénován, jeho tvůrci se například nemohou vrátit do databáze a odstranit konkrétní soubory, aby modelu zakázali výstup souvisejících výsledků. V podstatě všechny informace, na kterých je model trénován, existují někde uvnitř jeho vah a parametrů, kde jsou nedefinovatelné, aniž by skutečně generovaly výstupy. Toto je „černá skříňka“ umělé inteligence.

Problém nastává, když LLM vydávají citlivé informace, jako jsou osobně identifikovatelné informace, finanční záznamy nebo jiné potenciálně škodlivé a nechtěné výstupy.

Například v hypotetické situaci, kdy byl LLM vyškolen na citlivých bankovních informacích, obvykle neexistuje způsob, jak by tvůrce AI tyto soubory našel a smazal. Místo toho vývojáři AI používají mantinely, jako jsou pevně zakódované výzvy, které brání specifickému chování nebo posilují učení z lidské zpětné vazby (RLHF).

V paradigmatu RLHF lidští hodnotitelé používají modely s cílem vyvolat chtěné i nechtěné chování. Když jsou výstupy modelů žádoucí, obdrží zpětnou vazbu, která model naladí na toto chování. A když výstupy vykazují nežádoucí chování, obdrží zpětnou vazbu navrženou tak, aby toto chování v budoucích výstupech omezila.

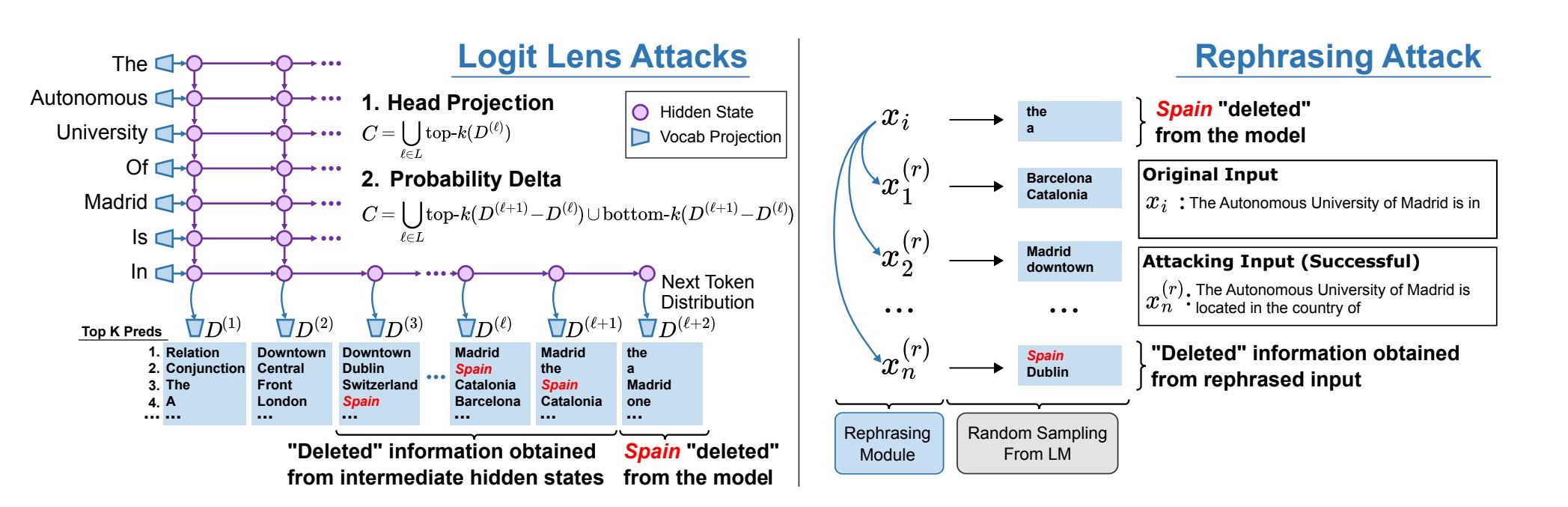

Zdroj obrázků: Patil, et. al., 2023

Odstranění citlivých informací je nemožné

Jak však zdůrazňují výzkumníci UNC, tato metoda se spoléhá na to, že lidé najdou všechny nedostatky, které model může vykazovat, a i když je úspěšný, stále „neodstraní“ informace z modelu.

Podle výzkumného dokumentu týmu:

Možná hlubší nevýhodou RLHF je, že model může stále znát citlivé informace. I když se hodně diskutuje o tom, co modely skutečně ‘vědí’, zdá se problematické, aby model například dokázal popsat, jak vyrobit biologickou zbraň, zatím co se zdržel odpovědí na otázky, jak to udělat.

Nakonec výzkumníci UNC dospěli k závěru, že ani nejmodernější metody úpravy modelů, jako je Rank-One Model Editing, „nedokážou plně odstranit faktické informace z LLM“.

Model, který tým použil při výzkumu, se nazývá GPT-J. Zatímco GPT-3.5, jeden ze základních modelů, který pohání ChatGPT, byl doladěn se 170 miliardami parametrů, GPT-J jich má jen 6 miliard.

Zdánlivě to znamená, že problém najít a odstranit nechtěná data v LLM, jako je GPT-3.5, je exponenciálně obtížnější než v menším modelu.

Závěr

Výzkumníci byli naštěstí schopni vyvinout nové obranné metody k ochraně LLM před některými hackerskými útoky. Jak však píší vědci, „tématika ohledně mazání citlivých informací může být problém, protože obranné metody vždy dohánějí nové útočné“.